Quando il porno incontra l’IA

Le tecnologie ed in particolare l’intelligenza artificiale si stanno evolvendo a velocità notevoli ma i governi non sanno stare al passo.

Senza regolamentazione la creazione di immagini e video espliciti è sempre più diffusa e soprattutto profittevole per le piattaforme, che lucrano su diritti non protetti.

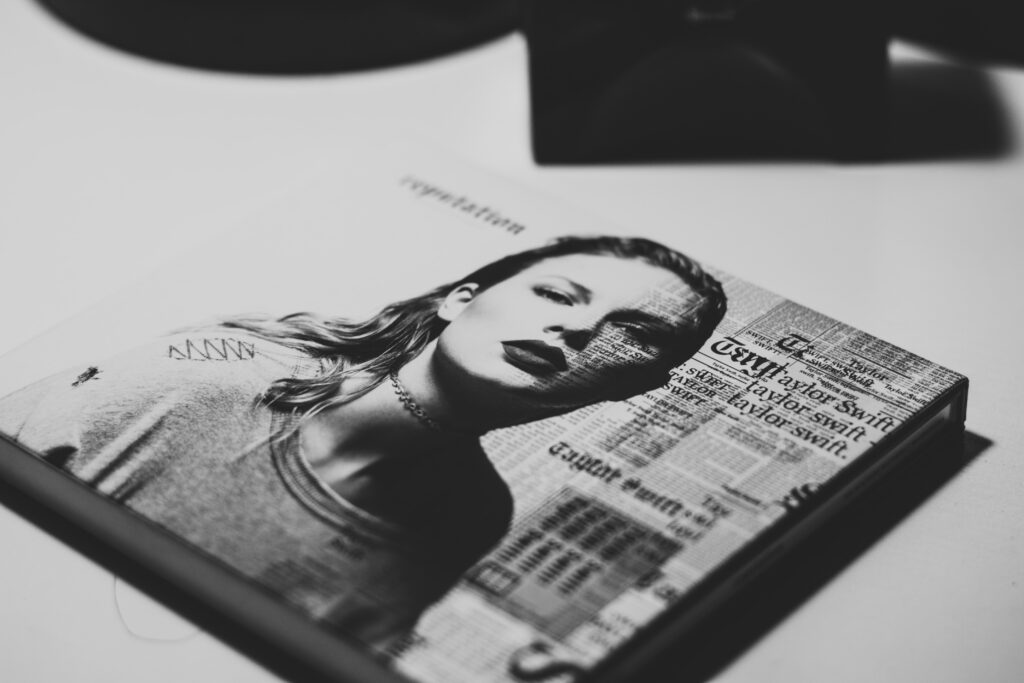

Pochi giorni fa il celebre social X ha reso impossibile cercare «Taylor Swift» nella barra di ricerca a seguito della diffusione di immagini e video porno ritraenti in apparenza il viso della cantante. In apparenza esatto, poiché il video è in realtà stato creato tramite un’ intelligenza artificiale.

Per quanto questo costituisca un danno terribile all’immagine della cantante, ha permesso di portare alla luce un problema totalmente ignorato dalle cronache fino a questo momento. Stiamo parlando del deepnude, ovvero la creazione di immagini/video deepfake che ritraggono corpi nudi con le sembianze di una persona (non presente) ottenuto attraverso l’utilizzo di programmi di Photoshop. Il nome lo deve a un Bot di Telegram che permetteva la creazione e diffusione di questi materiali.

Le vittime, per il 90% di genere femminile, sono già molte ed in diverse parti del mondo.

Nel settembre 2023 ad esempio, nella città di Almendralejo in Spagna le forze dell’ordine hanno ricevuto ben 11 denunce di ragazze, tutte minorenni, vittime di deepfake. La Spagna si presenta come uno dei paesi più all’avanguardia nella difesa del consenso e in generale della tutela delle donne ed è dunque stato possibile agire in modo rapido e deciso sugli attori del crimine.

Tuttavia il vuoto legislativo sul deepnude, così come su quasi tutte le creazioni prodotte dall’IA, sta creando notevoli problemi, soprattutto nei paesi dove la regolamentazione sui diritti della donna, sul consenso, o sulla privacy è pericolosamente carente.

Ovviamente non parlo di solo di donne, poiché questo tipo di violenza e deregolamentazione tocca tutti i generi. Tuttavia, secondo i dati di Pornhub del 2023, i maggiori fruitori di materiale pornografico sono uomini (70% contro 30% di donne in media) ed il 69% di vittime di revenge porn sono donne. Non si contano poi il numero di donne che si sono uccise, che hanno avuto problemi relazionali, psicologici, nell’ambiente lavorativo e la cui vita è stata impattata per sempre da questa violenza gratuita.

In Italia a livello legislativo al momento attuale ci si può proteggere? La risposta è si, più o meno.

Non ci si può appellare all’articolo 612 ter del Codice penale per il revenge porn, che punisce sia la condotta del soggetto che diffonde il materiale sia di quello che lo condivide, offrendo una tutela quindi anche dal fenomeno della viralità. Non essendoci però una regola per quanto riguarda immagini create con intelligenza artificiale, non è possibile applicare la legge per analogia (art. 1 Cp e 25 Cost.).

Si valuta dunque a seconda dei casi, quale delle ipotesi criminose già esistenti per legge possono essere invocate. Se il fatto integra gli estremi dell’estorsione o della diffamazione ci si può avvalere delle leggi relative, ad esempio. Questo sistema deve essere temporaneo, poiché manchevole, ed è necessario venga sostituito il prima possibile da leggi apposite, che prendano in considerazione tutti gli aspetti del deepnude, un fenomeno complesso che integra la sostituzione di persona, la diffamazione e la frode informatica, il tutto in ambito sessuale/pornografico (il che ci si augura costituisca un aggravante).

In realtà qualcosa a livello europeo bolle in pentola da un po’. Si parla dell’AI Act, un accordo che dovrebbe prevedere secondo il comunicato che « i modelli di fondazione debbano soddisfare specifici obblighi di trasparenza prima di essere immessi sul mercato».

L’accordo riguarderebbe tecnologie come GPT 4 (quindi ChatGPT e simili) ma anche LaMDA (il sistema dietro Google Bard). Questo è il punto che interesserebbe la manipolazione di immagini, e quindi la responsabilità che i sistemi di AI dovrebbero avere in termini di trasparenza, tutela della privacy ed annessi.

In America invece, proprio a fine gennaio 2024, è stato introdotto il DEFIANCE Act (Disrupt Explicit Forged Images and Non-Consensual Edits Act), che permetterebbe alle vittime di ottenere un risarcimento da chi ha prodotto o posseduto consapevolmente l’immagine manipolata digitalmente con l’intenzione di diffonderla.

Il capogruppo della maggioranza al Senato Dick Durbin, che si è occupato dell’Act, ha infatti affermato:

«Although the imagery may be fake, the harm to the victims from the distribution of sexually explicit ‘deepfakes’ is very real. Victims have lost their jobs, and they may suffer ongoing depression or anxiety. By introducing this legislation, we’re giving power back to the victims, cracking down on the distribution of ‘deepfake’ images, and holding those responsible for the images accountable.»

Ribadisco che una legge ben costruita dovrebbe prendere in considerazione non solo il fatto che il prodotto dell’IA sia falso e privo di consenso ma soprattutto che coinvolga materiale sessualmente esplicito e che questo contribuisca in misura ancora maggiore a ledere i diritti della persona.

Se volete approfondire il tema e scoprire la storia di milioni di altre persone vittime di deepfake, vi consiglio di sbirciare il sito Myimagemychoice, un movimento culturale ingaggiato contro la diffusione di immagini deepfake e deepnude, evidenziando come Google, Visa, Verizon non agendo stiamo traendo profitto da questo tipo di contenuti, che sappiamo tutti essere molto redditizi. Il movimento ha creato sulla vicenda un documentario dal titolo ANOTHER BODY, che spiega nel profondo cosa le vittime di deepnude hanno dovuto subire e subiscono oggi.

Non è ammissibile che si ripeta lo “scandalo di Pornhub” versione IA. I governi devono agire affinchè le segnalazioni alle piattaforme vengano prese in considerazione ed i video vengano bannati il più in fretta possibile. Considerando il progresso tecnologico raggiunto è inaccettabile che non esistano sistemi di controllo decenti dei materiali che vengono caricati in rete ogni giorno.

Sofia Seghesio

Leggi anche: Diritto d’autore e intelligenza artificiale: tutele e criticità